Errores Legendarios: Fallos de software que nos enseñaron valiosas lecciones

¡Bienvenidos a HistoriaCompu! Sumérgete en el fascinante mundo de la evolución tecnológica, donde te llevaremos en un viaje a través de los hitos más destacados de la computación. Desde las máquinas pioneras hasta las revoluciones digitales más recientes, nuestro artículo principal "Errores Legendarios: Fallos de software que nos enseñaron valiosas lecciones" te invita a descubrir cómo los fallos de software han moldeado la historia de la tecnología. Prepárate para desentrañar los secretos detrás de estos errores y las valiosas lecciones que nos han dejado. ¿Estás listo para explorar la historia de la computación?

- Introducción a los fallos de software como herramientas de aprendizaje

- El error que paralizó a AT&T: El colapso de la red telefónica en 1990

- La sonda Mars Climate Orbiter y el error de métricas

- El bug del Pentium FDIV y la precisión computacional

- Fallos de software en la bolsa: El Flash Crash de 2010

- El caos del Aeropuerto de Heathrow: Inauguración del Terminal 5

- Heartbleed: Un fallo de seguridad que sacudió Internet

- Errores de software y su impacto en la industria automotriz

- El efecto 2000: Un fallo de software que enseñó a planificar el futuro

- Lecciones globales para el desarrollo de software

- Conclusión: Cultura positiva de aprendizaje a través de fallos de software

-

Preguntas frecuentes

- 1. ¿Cuál es la importancia de estudiar los fallos de software en la historia de la computación?

- 2. ¿Cuáles son algunos ejemplos destacados de fallos de software en la historia de la computación?

- 3. ¿Cómo han impactado los fallos de software en la evolución de la computación?

- 4. ¿Qué lecciones importantes han surgido de los fallos de software a lo largo del tiempo?

- 5. ¿De qué manera los fallos de software han contribuido al perfeccionamiento de la industria tecnológica?

- Reflexión final: Lecciones eternas en el mundo de la tecnología

Introducción a los fallos de software como herramientas de aprendizaje

Los fallos de software, a menudo considerados como problemas frustrantes, también pueden convertirse en valiosas lecciones para los desarrolladores, usuarios y la industria en general. A lo largo de la historia de la computación, han ocurrido fallos de software que han tenido un impacto significativo, enseñando lecciones fundamentales sobre la importancia de la calidad, la seguridad y la fiabilidad en el desarrollo de software.

Explorar estos errores legendarios nos brinda la oportunidad de comprender cómo han evolucionado las prácticas de desarrollo de software, así como de reflexionar sobre las lecciones que han dejado a su paso. Estos fallos no solo han contribuido a la mejora de las tecnologías que utilizamos a diario, sino que también han impulsado avances en la forma en que se concibe, crea y prueba el software.

Nos sumergiremos en algunos de los fallos de software más notorios de la historia, analizando las lecciones que nos han dejado y destacando cómo han impactado en la forma en que se desarrollan y utilizan las aplicaciones y sistemas en la actualidad.

El error que paralizó a AT&T: El colapso de la red telefónica en 1990

En 1990, la red telefónica de AT&T experimentó un colapso masivo que afectó a millones de usuarios en Estados Unidos. El incidente tuvo su origen en un error en el sistema de señalización nº 7, utilizado para la gestión de llamadas y comunicaciones a nivel nacional.

El fallo en el sistema de señalización nº 7 provocó una interrupción catastrófica en el servicio telefónico, dejando a los usuarios sin la capacidad de realizar llamadas o acceder a servicios de emergencia. Este evento puso de manifiesto la vulnerabilidad de las redes de comunicaciones a nivel nacional y generó una gran preocupación en torno a la fiabilidad de las infraestructuras tecnológicas críticas.

El incidente del colapso de la red telefónica en 1990 sirvió como un recordatorio contundente de la importancia de implementar medidas de seguridad y redundancia en las infraestructuras de comunicaciones. A raíz de este suceso, se reforzaron los estándares de gestión de riesgos y se introdujeron protocolos de redundancia para garantizar la continuidad del servicio en caso de fallos catastróficos.

Impacto del fallo en las comunicaciones a nivel nacional

El colapso de la red telefónica de AT&T tuvo un impacto significativo en las comunicaciones a nivel nacional, afectando a millones de usuarios y empresas. La interrupción de servicio generó caos y confusión, evidenciando la importancia crítica de las redes de comunicaciones en la sociedad moderna.

El fallo en el sistema de señalización nº 7 expuso las deficiencias en la infraestructura de comunicaciones a nivel nacional, lo que llevó a una revisión exhaustiva de los protocolos de seguridad y la implementación de medidas para prevenir futuros colapsos de magnitud similar.

El impacto del fallo en las comunicaciones a nivel nacional sirvió como un catalizador para el fortalecimiento de las infraestructuras tecnológicas críticas y la adopción de prácticas más robustas en la gestión de riesgos y la redundancia de sistemas.

Lecciones aprendidas en gestión de riesgos y redundancia

El colapso de la red telefónica en 1990 dejó una huella imborrable en la industria de las comunicaciones, enseñando lecciones valiosas en cuanto a la gestión de riesgos y la importancia de la redundancia en los sistemas críticos. Este suceso impulsó a las empresas y a los organismos reguladores a reevaluar sus enfoques en materia de seguridad y continuidad del servicio.

Las lecciones aprendidas a raíz de este fallo llevaron a la implementación de medidas más rigurosas en la gestión de riesgos, incluyendo pruebas exhaustivas de resiliencia y la adopción de sistemas redundantes para mitigar el impacto de posibles fallos en el futuro.

En definitiva, el colapso de la red telefónica en 1990, originado por un fallo en el sistema de señalización nº 7, fue un punto de inflexión en la historia de las comunicaciones, que condujo a importantes avances en la gestión de riesgos y la redundancia de sistemas a nivel nacional.

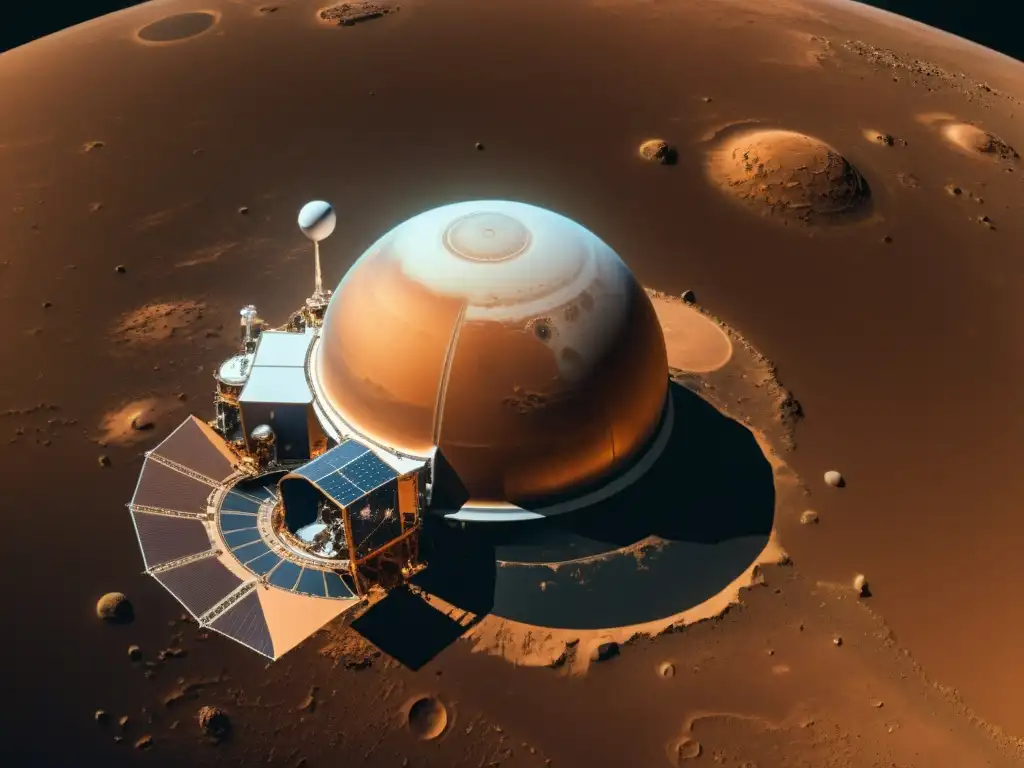

La sonda Mars Climate Orbiter y el error de métricas

Error de conversión entre sistemas métricos e imperiales

Uno de los fallos de software más notorios ocurrió en septiembre de 1999, cuando la sonda Mars Climate Orbiter, una misión de la NASA, se perdió en el espacio debido a un error de conversión entre sistemas métricos e imperiales. La nave espacial se acercó demasiado a Marte y se desintegró en la atmósfera marciana, resultando en la pérdida de la misión y un costo aproximado de 327 millones de dólares.

El fallo se originó en el software de navegación de la sonda, donde los ingenieros de la NASA utilizaron el sistema métrico para realizar cálculos, mientras que el equipo de la empresa contratista Lockheed Martin utilizó el sistema imperial. Este error de comunicación llevó a que las operaciones de la sonda se basaran en medidas incorrectas, lo que resultó en la tragedia.

Este incidente sirvió como una advertencia para la importancia de la precisión en el desarrollo de software, así como la necesidad de establecer protocolos claros de comunicación y coordinación entre los equipos involucrados en proyectos espaciales y tecnológicos de gran envergadura.

La pérdida de una misión de 327 millones de dólares

La pérdida de la sonda Mars Climate Orbiter debido a un fallo de software de conversión entre sistemas métricos e imperiales representó un duro golpe para la NASA, resultando en la desaparición de una misión valorada en 327 millones de dólares. Este incidente no solo significó una pérdida financiera significativa, sino que también puso en evidencia la importancia crítica de la precisión y la verificación en el desarrollo de software para misiones espaciales.

El costo de la misión perdida y el impacto en la reputación de la NASA sirvieron como recordatorio de las consecuencias graves que pueden surgir de un error de software, especialmente en entornos donde la precisión y la fiabilidad son fundamentales. Este lamentable suceso generó un impulso renovado para mejorar los procesos de desarrollo de software y establecer protocolos más estrictos para evitar errores similares en el futuro.

La lección aprendida a partir de la pérdida de la sonda Mars Climate Orbiter enfatizó la necesidad de integrar controles de calidad rigurosos, pruebas exhaustivas y protocolos de verificación para garantizar la precisión y la compatibilidad de los sistemas de software en misiones críticas y proyectos tecnológicos de gran escala.

Estableciendo nuevos protocolos en la NASA

Tras la pérdida de la sonda Mars Climate Orbiter, la NASA implementó cambios significativos en sus protocolos de desarrollo de software y procedimientos de coordinación. Se establecieron nuevas directrices para garantizar la uniformidad en el uso de sistemas de medición, así como la implementación de controles de calidad más estrictos y una supervisión más rigurosa en todas las etapas del desarrollo de software para misiones espaciales.

Además, este incidente llevó a la NASA a revisar y mejorar sus procesos de comunicación y colaboración entre los equipos internos y los contratistas externos, con el objetivo de mitigar el riesgo de errores y malentendidos en futuras misiones y proyectos espaciales. La agencia espacial reforzó su enfoque en la capacitación del personal y la promoción de una cultura de responsabilidad y rigor técnico en el desarrollo de software para sus misiones.

En última instancia, la trágica pérdida de la sonda Mars Climate Orbiter impulsó a la NASA a reevaluar y fortalecer sus prácticas de desarrollo de software, estableciendo un legado de lecciones aprendidas que continúan influyendo en la forma en que la agencia aborda la ingeniería de software para sus misiones espaciales.

El bug del Pentium FDIV y la precisión computacional

Descubrimiento y análisis del error en el cálculo de punto flotante

El bug del Pentium FDIV fue un hito significativo en la historia de los fallos de software. Descubierto en 1994 por Thomas Nicely, un profesor de matemáticas de la Universidad de Lynchburg, este error afectaba el cálculo de punto flotante en el procesador Pentium de Intel. Nicely encontró que en determinadas operaciones matemáticas, el chip producía resultados incorrectos en el último dígito decimal.

Este descubrimiento llevó a Intel a realizar un análisis detallado del error. Tras una investigación exhaustiva, se confirmó que el problema radicaba en una tabla de constantes numéricas utilizada en el cálculo de punto flotante, lo que generaba inexactitudes en ciertas operaciones aritméticas.

El error fue un duro golpe para Intel, ya que afectaba la confianza de los consumidores en la fiabilidad de sus procesadores, que en ese momento eran ampliamente utilizados en computadoras personales y servidores.

La respuesta de Intel y el impacto en la confianza del consumidor

Ante la revelación del bug del Pentium FDIV, Intel inicialmente minimizó el problema, argumentando que las operaciones afectadas por el error rara vez ocurrirían en aplicaciones del mundo real. Sin embargo, la presión y el escrutinio público llevaron a la compañía a cambiar de postura.

Finalmente, Intel reconoció el error y anunció un programa de reemplazo para todos los usuarios que solicitaran un nuevo procesador. Esta acción le costó a la empresa alrededor de 475 millones de dólares, pero fue crucial para restaurar la confianza de los consumidores en la calidad de sus productos.

El bug del Pentium FDIV dejó una huella indeleble en la percepción pública de Intel, sirviendo como un recordatorio poderoso de la importancia de la transparencia y la responsabilidad en la industria tecnológica.

Cómo este fallo cambió los estándares de calidad y prueba de chips

El impacto del bug del Pentium FDIV trascendió la esfera de la ingeniería de software y hardware. Este incidente provocó una revisión profunda de las prácticas de control de calidad y prueba de chips en la industria de semiconductores. Las empresas comenzaron a adoptar estándares más rigurosos y protocolos de prueba exhaustivos para evitar errores similares en el futuro.

Además, el bug del Pentium FDIV impulsó la creación de organizaciones independientes dedicadas a la evaluación y verificación de la precisión computacional en procesadores y otros componentes de computadoras. Estas entidades desempeñan un papel crucial en la validación de la precisión y fiabilidad de los productos de hardware, contribuyendo a la prevención de fallos catastróficos en la computación moderna.

Fallos de software en la bolsa: El Flash Crash de 2010

El Flash Crash de 2010 fue un evento que sacudió los cimientos del mercado financiero. En cuestión de minutos, el Dow Jones Industrial Average cayó alrededor de 600 puntos, para luego recuperarse casi completamente. Este fenómeno, que tuvo lugar el 6 de mayo, fue atribuido a un algoritmo de trading de alta frecuencia, el cual provocó una serie de transacciones automatizadas que desencadenaron un efecto dominó en el mercado.

El algoritmo en cuestión, conocido como el algoritmo de Spoofing, fue diseñado para realizar operaciones a alta velocidad, con la intención de obtener beneficios a partir de pequeñas fluctuaciones en los precios de las acciones. Sin embargo, en este caso, sus acciones desencadenaron un caos en el mercado, generando pérdidas masivas en cuestión de minutos.

Este incidente puso de manifiesto los peligros de la falta de regulación y supervisión en el ámbito de las transacciones financieras automatizadas, así como la importancia de implementar sistemas de seguridad más sólidos y mecanismos de control más estrictos para prevenir futuros colapsos del mercado debido a fallos de software.

Investigación y consecuencias del fallo

Tras el Flash Crash, se llevó a cabo una exhaustiva investigación por parte de la Comisión de Valores y Bolsa de Estados Unidos (SEC, por sus siglas en inglés) y la Comisión de Negociación de Futuros de Materias Primas (CFTC, por sus siglas en inglés), con el objetivo de determinar las causas precisas del incidente y tomar medidas para evitar que situaciones similares se repitieran en el futuro.

Como resultado de esta investigación, se implementaron nuevas regulaciones para supervisar y controlar el trading de alta frecuencia, así como para fortalecer los sistemas de seguridad en los mercados financieros. Se establecieron límites en las fluctuaciones de precios de las acciones y se introdujeron medidas para detener automáticamente las operaciones que generaran movimientos bruscos en el mercado, con el fin de evitar colapsos como el ocurrido durante el Flash Crash.

Además, este incidente sirvió como un recordatorio de la importancia de la transparencia y la supervisión en los mercados financieros, así como de la necesidad de evaluar cuidadosamente los riesgos asociados con la automatización de las transacciones y el uso de algoritmos de trading de alta frecuencia.

Regulaciones y sistemas de seguridad post-Flash Crash

Tras el Flash Crash, se implementaron nuevas regulaciones para supervisar y controlar el trading de alta frecuencia, así como para fortalecer los sistemas de seguridad en los mercados financieros. Se establecieron límites en las fluctuaciones de precios de las acciones y se introdujeron medidas para detener automáticamente las operaciones que generaran movimientos bruscos en el mercado, con el fin de evitar colapsos como el ocurrido durante el Flash Crash.

Además, este incidente sirvió como un recordatorio de la importancia de la transparencia y la supervisión en los mercados financieros, así como de la necesidad de evaluar cuidadosamente los riesgos asociados con la automatización de las transacciones y el uso de algoritmos de trading de alta frecuencia.

El caos del Aeropuerto de Heathrow: Inauguración del Terminal 5

Errores en el sistema de manejo de equipaje

En el año 2008, el Aeropuerto de Heathrow en Londres vivió uno de los episodios más caóticos de su historia con la apertura del Terminal 5. La pesadilla comenzó con fallos en el sistema de manejo de equipaje, lo que resultó en la pérdida y retraso de miles de maletas. Los problemas técnicos se tradujeron en un desastroso inicio para lo que se suponía sería un hito de la aviación.

El software encargado de gestionar el flujo de equipaje no fue capaz de lidiar con la cantidad de datos y operaciones necesarias en un entorno tan demandante como un aeropuerto internacional. Este incidente, además de provocar un gran malestar entre los pasajeros, puso en evidencia la importancia de contar con sistemas de software robustos y capaces de resistir condiciones de alto estrés y volumen de operaciones.

Las lecciones aprendidas de este fiasco han sido fundamentales para el desarrollo de sistemas de gestión de equipaje más eficientes y confiables, impulsando así la innovación en la industria aeroportuaria.

Impacto en vuelos y pasajeros: Un caso de logística fallida

El impacto en los vuelos y en la experiencia de los pasajeros fue inmenso. Se registraron cancelaciones y retrasos masivos, generando un caos logístico que afectó a miles de viajeros. La confianza en la aerolínea y en el aeropuerto se vio seriamente comprometida, lo que tuvo consecuencias a largo plazo en términos de reputación y pérdida de clientes.

Este incidente puso de manifiesto la importancia de la logística y la integración de sistemas en entornos críticos como el transporte aéreo. La incapacidad de gestionar de manera eficiente el flujo de equipaje no solo afectó la operatividad del aeropuerto, sino que también repercutió en la percepción de calidad del servicio por parte de los pasajeros.

Este desastroso evento sirvió como un recordatorio de la necesidad de realizar pruebas exhaustivas de estrés y de contar con planes de contingencia sólidos para hacer frente a situaciones imprevistas en el ámbito de la logística aeroportuaria.

Mejoras en la integración de sistemas y pruebas de estrés

Tras este incidente, se implementaron mejoras significativas en los sistemas de gestión de equipaje y en la integración de software en el Aeropuerto de Heathrow. Se reforzaron los protocolos de pruebas de estrés y se llevaron a cabo simulaciones más exhaustivas para evaluar la capacidad de respuesta del sistema ante situaciones límite.

Además, se establecieron medidas para garantizar una mayor interoperabilidad entre los sistemas de distintas áreas del aeropuerto, lo que permitiría una gestión más eficiente y coordinada ante eventualidades. Estas acciones han sentado un precedente en la industria de la aviación, promoviendo estándares más rigurosos en cuanto a la fiabilidad y robustez de los sistemas de software en entornos críticos.

El desafío que representó el fiasco del Terminal 5 en el Aeropuerto de Heathrow ha dejado valiosas lecciones que han contribuido a elevar los estándares de calidad y seguridad en la gestión aeroportuaria, demostrando que incluso los errores más costosos pueden convertirse en catalizadores de avances significativos en el desarrollo de software y sistemas de logística.

Heartbleed: Un fallo de seguridad que sacudió Internet

¿Qué fue Heartbleed y cómo afectó la criptografía en la web?

Heartbleed fue una vulnerabilidad de seguridad descubierta en el software de cifrado OpenSSL en abril de 2014. Esta falla permitía a los atacantes acceder a la información sensible protegida por OpenSSL, incluidas las claves privadas utilizadas para asegurar las comunicaciones en línea. La magnitud del problema fue significativa, ya que OpenSSL es ampliamente utilizado en servidores web, lo que significa que una gran cantidad de sitios web y servicios en línea estaban potencialmente expuestos.

El impacto de Heartbleed en la criptografía en la web fue considerable. La confianza en la seguridad de las comunicaciones en línea se vio socavada, lo que llevó a una reevaluación de las prácticas de seguridad y a una mayor atención en la detección temprana de vulnerabilidades en el software utilizado en infraestructuras críticas de Internet.

Este incidente resaltó la importancia de la seguridad en el desarrollo de software y la necesidad de una supervisión continua para identificar y abordar vulnerabilidades de manera proactiva.

El proceso de detección y reacción ante vulnerabilidades graves

La detección de Heartbleed fue un hito significativo en la evolución de la seguridad informática. Puso de manifiesto la importancia de las auditorías de seguridad exhaustivas y la necesidad de realizar pruebas rigurosas para identificar posibles vulnerabilidades antes de que sean explotadas por agentes malintencionados.

La reacción ante Heartbleed también fue un punto de inflexión en la forma en que la comunidad de seguridad informática y los proveedores de software responden a las vulnerabilidades graves. Se implementaron parches de seguridad de emergencia y se llevaron a cabo campañas de concientización para informar a los usuarios sobre la importancia de actualizar sus sistemas y cambiar sus contraseñas para mitigar el impacto de la vulnerabilidad.

Este episodio demostró la necesidad de una colaboración estrecha entre los desarrolladores de software, los investigadores de seguridad y los usuarios finales para abordar de manera efectiva las vulnerabilidades críticas y proteger la integridad de la infraestructura digital.

Impulsando una nueva era en la seguridad de software

La revelación de Heartbleed marcó un cambio significativo en la percepción y el enfoque hacia la seguridad del software. Los desarrolladores y los responsables de la seguridad comenzaron a priorizar la revisión exhaustiva del código, la implementación de prácticas de desarrollo seguro y la adopción de procesos de respuesta a incidentes más ágiles.

Además, este evento catalizador motivó la creación de iniciativas de seguridad de software más colaborativas y transparentes, como el establecimiento de programas de recompensas por vulnerabilidades y la promoción de estándares de codificación segura. Estas medidas han contribuido a fortalecer la resistencia de la infraestructura digital contra amenazas emergentes y a fomentar una cultura de seguridad proactiva en la comunidad de desarrollo de software.

Heartbleed no solo reveló las deficiencias en la seguridad de software a nivel global, sino que también generó un impulso transformador hacia un ecosistema de desarrollo de software más seguro, resiliente y preparado para enfrentar los desafíos de seguridad del siglo XXI.

Errores de software y su impacto en la industria automotriz

El caso del acelerador de Toyota y los fallos de software

En 2009, Toyota se vio envuelta en una crisis tras numerosos informes de aceleración involuntaria en varios de sus modelos. Tras una exhaustiva investigación, se descubrió que estos incidentes estaban vinculados a un fallo en el software que controlaba el sistema de aceleración. Este error de software causaba que el pedal del acelerador quedara atascado, haciendo que el vehículo acelerara sin control por parte del conductor.

El impacto de estos fallos de software en la reputación de Toyota fue significativo. La confianza de los consumidores se vio afectada, y la compañía enfrentó críticas por su aparente falta de control de calidad en el desarrollo de software para sus vehículos.

Este caso se convirtió en un ejemplo icónico de los peligros que pueden surgir a raíz de un error de software en un producto de consumo masivo, como un automóvil.

Consecuencias legales y llamados a revisión masivos

Las consecuencias legales de los fallos de software en los vehículos de Toyota fueron significativas. La compañía enfrentó demandas por parte de conductores afectados, lo que resultó en costosos acuerdos y litigios. Además, se vio obligada a realizar llamados a revisión masivos para solucionar el problema, lo que tuvo un impacto financiero considerable en la empresa.

Este caso puso de manifiesto la importancia de la responsabilidad legal de las empresas en relación con los errores de software en productos que pueden poner en riesgo la seguridad de los usuarios. También evidenció la necesidad de implementar procesos rigurosos de control de calidad y pruebas exhaustivas en el desarrollo de software para productos de uso cotidiano.

La gestión de crisis y la respuesta rápida y efectiva ante problemas de software se convirtieron en áreas críticas para las empresas que desarrollan tecnología integrada en productos de consumo.

La importancia de la calidad del software en vehículos modernos

El caso del acelerador de Toyota subrayó la importancia crucial de la calidad del software en los vehículos modernos. Los sistemas informáticos integrados en los automóviles desempeñan un papel fundamental en la seguridad y el rendimiento del vehículo. Por lo tanto, la detección temprana de fallos de software y la implementación de medidas preventivas se han convertido en prioridades para los fabricantes de automóviles.

Este incidente también impulsó un cambio significativo en la forma en que se desarrolla y se prueba el software en la industria automotriz. Se destacó la necesidad de adoptar prácticas de desarrollo de software más rigurosas, incluyendo pruebas exhaustivas de seguridad y calidad, así como la implementación de mecanismos de respuesta rápida ante posibles fallos de software en el futuro.

El caso del acelerador de Toyota y sus fallos de software sirvió como un recordatorio contundente de que la calidad del software es un aspecto crítico en la fabricación de vehículos modernos, y que los errores en este ámbito pueden tener consecuencias graves tanto para los fabricantes como para los consumidores.

El efecto 2000: Un fallo de software que enseñó a planificar el futuro

El problema de la fecha en los sistemas informáticos surgió con la llegada del nuevo milenio, cuando se temía que los sistemas informáticos no estuvieran preparados para el cambio de fecha al año 2000. Este problema, conocido como el efecto 2000 o bug del milenio, generó preocupación en todo el mundo, ya que se temía que los sistemas informáticos fallaran al interpretar el año 2000 como 1900 debido a la representación de las fechas en formato de dos dígitos. Este escenario planteaba riesgos significativos para la infraestructura tecnológica, incluyendo sistemas bancarios, de transporte, de energía y de comunicaciones.

El impacto potencial de este fallo de software generó una amplia discusión y conciencia sobre la importancia de la integridad de los sistemas informáticos y la necesidad de implementar medidas preventivas para evitar futuros colapsos tecnológicos. El efecto 2000 ilustra claramente cómo un fallo de software puede destacar la importancia de la planificación y la actualización de sistemas para evitar consecuencias catastróficas.

Este incidente histórico sirvió como una lección crucial para la industria de la tecnología, impulsando la implementación de prácticas de desarrollo de software más rigurosas y la adopción de estándares de representación de fechas más sólidos, lo que demuestra que los fallos de software pueden ser catalizadores para el avance y la mejora en el campo de la informática.

Cómo el mundo se preparó para evitar el colapso tecnológico

Ante la inminente llegada del año 2000, gobiernos, empresas y organizaciones en todo el mundo emprendieron esfuerzos masivos para abordar y mitigar el impacto del efecto 2000. Se destinaron recursos significativos para identificar y corregir posibles fallos en el software, así como para actualizar los sistemas y garantizar su compatibilidad con el cambio de fecha.

Se llevaron a cabo extensas pruebas de software y simulaciones de escenarios para evaluar y prevenir posibles consecuencias del efecto 2000. Esta movilización global demostró la importancia de la colaboración y la coordinación a escala mundial para enfrentar desafíos tecnológicos de gran envergadura, sentando un precedente para la gestión de crisis tecnológicas futuras.

El efecto 2000 no solo evidenció la necesidad de preparación a nivel técnico, sino que también resaltó la importancia de la conciencia pública sobre los riesgos tecnológicos y la necesidad de tomar medidas proactivas para proteger la infraestructura crítica.

Planificación a largo plazo y actualizaciones de sistemas como medidas preventivas

Tras el impacto del efecto 2000, se implementaron cambios significativos en la planificación y el desarrollo de sistemas informáticos. Las lecciones aprendidas de este evento llevaron a una mayor atención a la planificación a largo plazo, la anticipación de posibles fallos de software y la implementación de actualizaciones periódicas de sistemas como medidas preventivas.

Las organizaciones comenzaron a adoptar enfoques más proactivos para la gestión de la tecnología, priorizando la seguridad y la estabilidad de los sistemas a largo plazo. La conciencia renovada sobre los riesgos asociados con los fallos de software impulsó la inversión en la mejora continua de la infraestructura tecnológica y la adopción de políticas de actualización y mantenimiento más sólidas.

En última instancia, el efecto 2000 sirvió como un recordatorio de la importancia de la vigilancia constante, la planificación a largo plazo y la adaptación continua de los sistemas informáticos para garantizar su fiabilidad y seguridad en un entorno tecnológico en constante evolución.

Lecciones globales para el desarrollo de software

La importancia de las pruebas exhaustivas y la calidad del código

Los fallos de software más notorios de la historia han dejado en claro la importancia de realizar pruebas exhaustivas y mantener altos estándares de calidad en el código. Desde el desastroso error de la misión Mariner 1 de la NASA en 1962, causado por un fallo en el software de navegación, hasta el incidente de la vacuna contra el COVID-19 en el estado de Virginia Occidental en 2021, donde un error en el software afectó la distribución, estos incidentes han subrayado la necesidad crítica de someter a rigurosas pruebas cada línea de código antes de su implementación.

La calidad del código es fundamental para prevenir fallos en el software. Un ejemplo icónico es el error de división por cero en el sistema de control de vuelo del avión Airbus A400M en 2015, que causó el fallo de uno de los motores durante un vuelo de prueba. Este suceso resalta la importancia de seguir las mejores prácticas de programación y de implementar sistemas de revisión de código que garanticen su integridad.

Estos fallos de software nos han enseñado que las pruebas exhaustivas y el mantenimiento de la calidad del código son pilares fundamentales para el desarrollo de software robusto y confiable.

Gestión de crisis y la comunicación efectiva con los usuarios

Los errores en el software también han evidenciado la importancia de una gestión de crisis efectiva y una comunicación clara con los usuarios. Casos como el fallo en el servicio de correo electrónico de Microsoft Outlook en 2019, que dejó a millones de usuarios sin acceso durante horas, han demostrado que la forma en que se maneja la crisis y se comunica con los afectados puede tener un impacto significativo en la percepción de la marca y la confianza del público.

La transparencia y la prontitud en la comunicación con los usuarios afectados son cruciales para mitigar los daños causados por un fallo de software. Por otro lado, la gestión de la crisis debe incluir la implementación rápida de soluciones temporales y la elaboración de un plan de acción claro para corregir el problema de manera definitiva.

Los fallos de software nos han enseñado que la gestión de crisis y la comunicación efectiva con los usuarios son aspectos fundamentales para minimizar el impacto de un error y preservar la confianza del público en la empresa o el producto.

De los errores a las mejores prácticas en el desarrollo de software

Finalmente, los fallos de software han impulsado la evolución de las mejores prácticas en el desarrollo de software. La adopción generalizada de metodologías ágiles como Scrum y Kanban, que priorizan la flexibilidad y la adaptación a los cambios, se ha visto influenciada por la necesidad de reducir los riesgos asociados a fallos catastróficos en el software.

Asimismo, la incorporación de la integración continua y la entrega continua (CI/CD) en los procesos de desarrollo de software ha sido impulsada por la necesidad de detectar y corregir errores de manera temprana y constante a lo largo del ciclo de vida del software.

Los fallos de software han catalizado la adopción de enfoques más flexibles y orientados a la prevención de errores en el desarrollo de software, lo que ha llevado a la consolidación de mejores prácticas que buscan garantizar la calidad y confiabilidad de las aplicaciones y sistemas informáticos.

Conclusión: Cultura positiva de aprendizaje a través de fallos de software

Los fallos de software, lejos de ser simplemente obstáculos en el desarrollo, son oportunidades para aprender y mejorar. Al explorar la historia de la computación, es evidente que muchos de los avances más significativos surgieron a raíz de errores y fallos. Estos fallos no solo enseñan lecciones valiosas, sino que también fomentan una cultura positiva de aprendizaje y mejora continua en el desarrollo de software.

Al abordar los fallos de software como oportunidades de crecimiento, los desarrolladores pueden identificar áreas de mejora, fortalecer la resiliencia del sistema y fomentar la innovación. La transparencia en torno a los fallos también promueve la confianza del usuario, ya que muestra un compromiso con la calidad y la mejora constante.

Los fallos de software no solo son enseñanzas valiosas, sino que también son catalizadores para la evolución y la excelencia en el desarrollo de software. Al adoptar una mentalidad de aprendizaje constante y mejora continua, los desarrolladores pueden transformar los fallos en oportunidades para innovar y fortalecer la calidad de sus productos.

Preguntas frecuentes

1. ¿Cuál es la importancia de estudiar los fallos de software en la historia de la computación?

Los fallos de software han sido cruciales para el avance de la tecnología, ya que enseñan lecciones valiosas sobre diseño, programación y control de calidad.

2. ¿Cuáles son algunos ejemplos destacados de fallos de software en la historia de la computación?

Entre los fallos de software más famosos se encuentran el error de la división por cero en el Intel Pentium FDIV, y el bug del milenio que afectó a sistemas informáticos en el cambio de siglo.

3. ¿Cómo han impactado los fallos de software en la evolución de la computación?

Los fallos de software han impulsado el desarrollo de mejores prácticas de programación, el establecimiento de estándares de calidad y la conciencia sobre la importancia de las pruebas exhaustivas.

4. ¿Qué lecciones importantes han surgido de los fallos de software a lo largo del tiempo?

Los fallos de software han resaltado la necesidad de la transparencia en la comunicación sobre errores, la importancia de la colaboración en la resolución de problemas y la relevancia de la planificación para contingencias.

5. ¿De qué manera los fallos de software han contribuido al perfeccionamiento de la industria tecnológica?

Los fallos de software han motivado a las empresas a invertir en investigación y desarrollo, y han fomentado una cultura de aprendizaje continuo y mejora constante en la industria tecnológica.

Reflexión final: Lecciones eternas en el mundo de la tecnología

Los fallos de software no son simplemente anécdotas del pasado, sino lecciones vivas que siguen moldeando nuestro presente tecnológico.

La historia nos recuerda constantemente que los errores del pasado tienen el poder de influir en nuestro presente y futuro. Como dijo Steve Jobs, a veces cuando innovas, cometes errores. Es mejor admitirlos rápidamente y seguir adelante

.

En última instancia, depende de cada uno de nosotros aprovechar estas lecciones para impulsar un cambio positivo en la forma en que desarrollamos y utilizamos la tecnología en nuestras vidas.

¡Únete a la comunidad de HistoriaCompu y descubre más secretos de la tecnología!

Queridos lectores de HistoriaCompu, gracias por ser parte de nuestra comunidad y por explorar con nosotros los fascinantes fallos de software que han dejado huella en la historia. Comparte este artículo para que más personas descubran estas lecciones tan importantes sobre la tecnología. ¿Tienes alguna anécdota sobre fallos de software que quieras compartir? ¿O te gustaría que escribiéramos sobre algún tema en particular? ¡Déjanos tus ideas en los comentarios y continuemos explorando juntos!

El Poder de la Simplicidad: Cómo las interfaces de usuario revolucionaron la informática

El Poder de la Simplicidad: Cómo las interfaces de usuario revolucionaron la informática El legado de las PDAs: ¿Cómo inspiraron a los smartphones modernos?

El legado de las PDAs: ¿Cómo inspiraron a los smartphones modernos? De Walkman a iPod: La revolución de la música portátil a través del tiempo

De Walkman a iPod: La revolución de la música portátil a través del tiempoSi quieres conocer otros artículos parecidos a Errores Legendarios: Fallos de software que nos enseñaron valiosas lecciones puedes visitar la categoría Productos y Servicios Tecnológicos.

Deja una respuesta

Articulos relacionados: